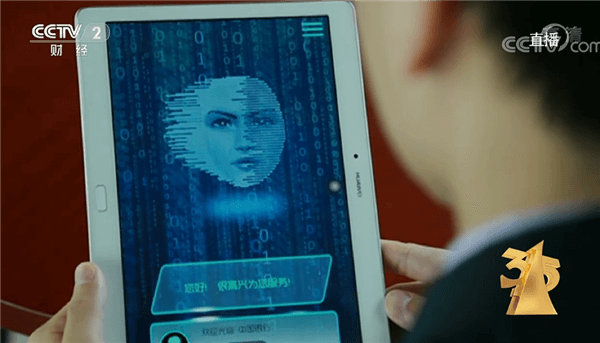

在今年的3·15信息安全实验室中,技术人员为大家介绍了不法分子利用AI换脸、变声技术进行违法犯罪的行为。通过AI人工智能技术,让AI换脸诈骗防不胜防。

AI换脸诈骗

- 案例一:四川泸州陈女士在睡梦中被电话惊醒,电话中传来了女儿的哭救声。随后“绑匪”称其女儿被绑架,让准备80万赎金。随后陈女士火速报警,经过警方调查,陈女士女儿并没有被绑架,诈骗分子先是用虚拟技术伪装电话号码,再用AI拟声技术实施了诈骗。

- 案例二:浙江温州陈先生接到国外好友求助,表示因国际漫游限制,需要他帮忙转账给航空公司。随后好友本人打来视频电话进行确认,但很快便以其他理由挂断。最终陈先生选择相信,加了航空经理微信转账49000余元受骗。

- 案例三:陕西西安某公司财务张女士接到老板视频要求转账给指定账号。随后她在上传电子凭证时发现不对劲,老板的微信既没有和她视频聊天,也没有下达转账的指示。最后在报警后,警方联系相关银行紧急止付才保住了大部分钱。

显然,这些案件背后都是犯罪分子利用AI技术对人的面部形象、说话声音进行了模仿。受害者眼见不一定为实,耳听的也有可能为虚。

根据315晚会介绍,AI换脸技术,只需要一张正脸照片,就能够将视频中的人脸进行置换。更可怕的是一种视频聊天实时换脸技术,可以将人脸照片直接替换视频聊天中,让照片根据你的人脸做动作,挤眉弄眼、聊天都不是问题。

同时,AI拟声技术早就被用来模拟声音了,只需要获取他人几秒钟的声音片段,就可以通过声纹技术模拟他人的声音。

但由于AI换脸变声技术目前还没成熟,在制造换脸视频或变声语音时,需要大量的数据和专业的算法。不法分子也只能制作一小段视频和语音,时间过长就会容易出现问题。因此,不法分子在利用AI技术进行诈骗时,往往不会与受害者进行长时间的视频或通话。

注意事项

在目前的技术条件下,想要在点对点的视频实时通话过程中,实现仿真程度极高的AI换脸是很难的,这需要绕过视频通话软件的安防体系,还需要投喂大量的数据、专业算法的支撑和不断迭代才可以实现。因此我们可以通过一些手段来进行防范AI变脸诈骗:

- 尽量不要在社交媒体上发布个人及家人相关照片、语音、视频等,以防被诈骗分子利用。

- 在视频通话的时候,如果觉得可疑的话,可以要求对方摸脸或者是按鼻子,因为这些动作会对面部数据造成干扰,伪造的人脸可能会产生抖动或闪现等问题。

- 不要随意接听陌生来电,不要轻易加陌生人微信或QQ,不要下载安装非正规APP,不要轻易点击陌生链接。

- 在电话或视频时,尽量不要涉及到钱财或个人隐私,可将网络转账的到账方式设置为延迟到账。

- 在手机端安装国家反诈中心APP,同时提高自身反诈意识,不轻信陌生的网络信息。如遇诈骗行为,可及时报警处理。

AI技术的发展会给我们的生活带来极大的便利,但也会带来很多风险。我们要提高自身的防骗意识,在涉及财产或转账等敏感问题时要仔细辨别真伪,避免上当受骗。

免责声明:素材源于网络,如有侵权,请联系删稿。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。